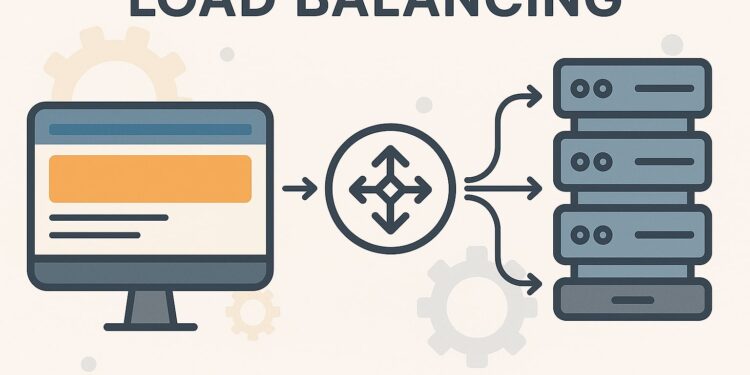

Na era dos serviços em nuvem e das aplicações web globais, a garantia do desempenho e da disponibilidade dos sistemas é fundamental. Um dos pilares essenciais para alcançar isso é o balanceamento de carga: uma técnica que distribui de maneira eficiente o tráfego ou as tarefas entre vários servidores.

Mas quais métodos estão disponíveis? Como escolher o mais adequado para sua infraestrutura? Abaixo, analisamos os principais algoritmos de balanceamento de carga, sua lógica interna, casos de uso e as reais vantagens e desvantagens.

O que é o balanceamento de carga?

O balanceamento de carga consiste em repartir as solicitações de entrada (HTTP, TCP, etc.) entre múltiplos servidores que oferecem o mesmo serviço. Seus principais objetivos incluem:

- Evitar gargalos (nenhum servidor fica sobrecarregado).

- Aumentar a disponibilidade (caso um servidor falhe, outros continuam funcionando).

- Reduzir a latência (escolhendo o servidor mais rápido ou menos ocupado).

- Escalonar horizontalmente de forma mais eficaz.

Essa técnica pode ser implementada em nível de hardware (aparelhos dedicados como F5 ou Citrix NetScaler) ou software (HAProxy, NGINX, Traefik, entre outros).

Principais algoritmos de balanceamento de carga

1. Round Robin (RR)

Como funciona: Atribui as solicitações de forma sequencial e cíclica: servidor 1, 2, 3… e retorna ao 1.

Quando usar: Servidores com mesma capacidade de processamento e aplicações sem persistência de sessão.

Vantagens:

- Fácil de implementar.

- Distribuição equitativa do tráfego.

Desvantagens:

- Não considera a carga real nem o desempenho atual dos nós.

2. Round Robin Ponderado

Como funciona: Atribui pesos aos servidores de acordo com sua capacidade. O servidor com maior peso recebe mais solicitações.

Quando usar: Quando os servidores têm capacidades dispares (CPU, RAM).

Vantagens:

- Melhor distribuição em ambientes heterogêneos.

- Aproveita melhor os recursos.

Desvantagens:

- A alocação é estática e não responde rapidamente a variações de carga em tempo real.

3. Least Connections

Como funciona: Escolhe o servidor com menos conexões ativas no momento.

Quando usar: Quando as conexões têm duração variável (ex: WebSockets).

Vantagens:

- Dinâmico e adaptativo.

- Evita sobrecarga.

Desvantagens:

- Requer medição constante de conexões.

4. Least Response Time

Como funciona: Envia a solicitação ao servidor com o menor tempo de resposta recente.

Quando usar: Sistemas onde a latência é crítica.

Vantagens:

- Otimiza a experiência do usuário.

- Adapta-se ao desempenho real.

Desvantagens:

- Requer infraestrutura de monitorização precisa.

5. IP Hash

Como funciona: Calcula um hash a partir do IP do cliente para determinar qual servidor atenderá a solicitação.

Quando usar: Necessidade de persistência de sessão.

Vantagens:

- Garante que um mesmo cliente sempre contate o mesmo servidor.

Desvantagens:

- Se um servidor falha, seu tráfego não é redistribuído automaticamente.

Casos reais de uso

- Facebook utiliza uma abordagem híbrida para distribuir o tráfego entre regiões.

- Google aplica balanceadores inteligentes baseados em dados em tempo real.

- Amazon Web Services (AWS) disponibiliza diversos tipos de balanceadores para diferentes níveis de rede.

Melhores práticas em produção

- Combine algoritmos.

- Use health checks para evitar direcionar tráfego a servidores caídos.

- Planeje falhas para garantir transições suaves.

- Escalone horizontalmente com auto-scaling.

- Monitore em tempo real.

- Simule cargas e falhas.

Conclusão

O balanceamento de carga é uma estratégia crítica para garantir disponibilidade, escalabilidade e desempenho em sistemas modernos. Cada algoritmo tem seu lugar e momento; a chave é conhecer as necessidades da sua infraestrutura e combinar as ferramentas e práticas adequadas. Isso fará uma diferença tangível na estabilidade e sucesso de aplicações, sejam APIs, ecommerces ou plataformas globais na nuvem.