A inferência como campo de batalha na Inteligência Artificial

A inferência emergiu como o novo campo de batalha na inteligência artificial, com modelos avançando para se tornarem sistemas agênticos que podem raciocinar em múltiplos passos e gerir contextos complexos. Para atender a essa demanda, a NVIDIA introduziu a GPU Rubin CPX, projetada especificamente para acelerar as cargas de trabalho de contexto massivo.

O Desafio da Inferência em Grande Escala

À medida que a IA se torna parte fundamental de várias indústrias, as exigências crescem. Por exemplo, assistentes de programação precisam analisar repositórios completos e suas interdependências. No campo de vídeos, a geração de conteúdos longos requer uma coesão mantida ao longo de horas, representando a necessidade de processar mais de um milhão de tokens.

Essas demandas sobrecarregam as infraestruturas convencionais, apenas aptas para contextos mais curtos, criando desafios em termos de memória, largura de banda e eficiência energética.

Inferência Desagregada: Separar para Otimizar

A NVIDIA propõe uma arquitetura de inferência desagregada, dividindo o processamento em duas fases distintas:

- Fase de Contexto: Intensiva em computação, onde grandes volumes de dados são ingeridos.

- Fase de Geração: Intensiva em memória, demandando transferências rápidas para a produção de resultados contínuos.

Essa separação permite uma otimização mais eficaz dos recursos, embora introduza complexidades adicionais na coordenação de caches e gerenciamento de memória.

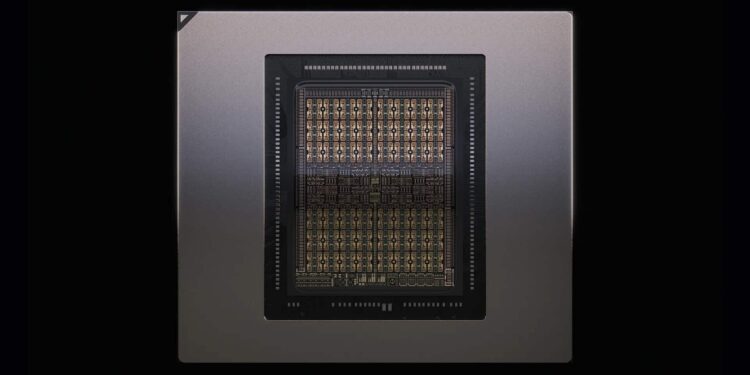

Rubin CPX: Aceleração para Contextos Massivos

A GPU Rubin CPX é uma solução para o gargalo na fase de contexto, oferecendo 30 petaFLOPs de computação, 128 GB de memória GDDR7 e três vezes mais aceleração em mecanismos de atenção em comparação com versões anteriores. Esses atributos a colocam em destaque para aplicações de alto valor, como desenvolvimento de software, geração de vídeos de alta definição e pesquisas em larga escala.

Vera Rubin NVL144 CPX: Potência em Escala ExaFLOP

A Rubin CPX é parte da arquitetura Vera Rubin NVL144 CPX, que agrega 144 GPUs para a fase de contexto e geração, além de 36 CPU, oferecendo uma capacidade impressionante de 8 exaFLOPs. Esta nova plataforma promete revolucionar a maneira como as empresas utilizam IA.

Economia da Inferência: ROI no Centro

Além do desempenho, a NVIDIA aponta um impacto econômico significativo. Com a Rubin CPX, espera-se um retorno sobre o investimento (ROI) de 30 a 50 vezes, gerando até 5 bilhões de dólares em receitas. Essa abordagem sugere uma mudança no foco, valorizando tokens processados de forma rentável.

Casos de Uso Transformadores

Os benefícios da Rubin CPX se refletem em aplicações práticas, desde desenvolvimento de software com compreensão profunda de repositórios a geração de vídeos coesos e pesquisa em tempo real em grandes bases de knowledge.

Ecosistema Preparado

A Rubin CPX se integra perfeitamente ao stack de software da NVIDIA, otimizando inferências de modelos de linguagem e potencializando as capacidades de inteligência artificial.

Disponibilidade

A NVIDIA espera que a Rubin CPX esteja disponível no final de 2026, alinhando-se à crescente demanda por inferência em larga escala.

Conclusão

Com a Rubin CPX, a NVIDIA não apenas apresenta mais uma GPU, mas também uma nova abordagem para a inferência, que redefine os padrões da inteligência artificial, focando na eficiência e viabilidade econômica. A plataforma Vera Rubin NVL144 CPX promete colocar a inferência maciça no centro das discussões tecnológicas e empresariais.