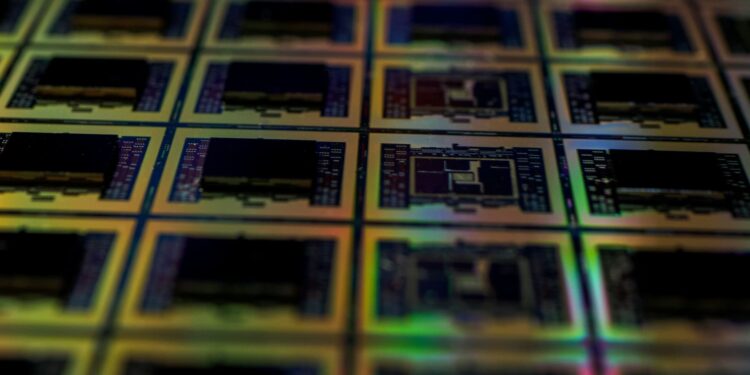

A corrida global pela Inteligência Artificial (IA) está reescrevendo o roteiro da indústria de semicondutores, com um segmento que se tornou um verdadeiro gargalo: a memória. Nesse contexto, novas estimativas de analistas têm destacado dois gigantes sul-coreanos — Samsung Electronics e SK hynix — cujas projeções, por sua magnitude, são difíceis de ignorar.

De acordo com previsões divulgadas em meios financeiros asiáticos, com base em estimativas de Morgan Stanley Research, o lucro operacional da Samsung pode chegar a aproximadamente 317 trilhões de wons em 2027, enquanto a SK hynix deve ficar em torno de 225 trilhões de wons. Juntas, essas cifras almejam mais de 542 trilhões de wons de lucro operacional combinado, equivalendo a centenas de bilhões de euros ou dólares, dependendo da taxa de câmbio. Isso gera um debate recorrente nos mercados: trata-se de um pico temporário ou o início de um “superciclo” de memória ligado à IA?

A explicação para esses números impressionantes não reside em smartphones ou laptops, mas sim em data centers. O aumento da IA generativa, modelos multimodais e a necessidade de inferência em larga escala impulsionaram a demanda por memória DRAM avançada, especialmente a HBM (High Bandwidth Memory), que acompanha GPUs e aceleradores tanto em cargas de treinamento quanto em inferência cada vez mais intensa.

As próprias empresas indicaram um cenário de tensão prolongada. Samsung e SK hynix alertaram que a escassez de chips de memória pode se estender até 2027, num ambiente em que o investimento em infraestrutura de IA pressiona a cadeia de suprimentos, mantendo os preços e margens elevados. Essa percepção também vem da indústria de equipamentos: a Applied Materials, um dos principais fornecedores de maquinário para fabricação de chips, associou sua perspectiva de negócios ao crescimento da IA e à demanda por memória, mencionando abertamente uma escassez global e um ciclo de investimento em alta.

No caso da Samsung, a unidade de semicondutores deve impulsionar esse giro, com uma estimativa de margem operacional em torno de 49% até 2027, especialmente acentuada nos números associados a semicondutores. Recentemente, a Samsung anunciou o início da produção em massa da HBM4, um avanço crucial para a nova onda de aceleradores de IA. Esse progresso ocorre em um mercado hipercompetitivo, onde ser o primeiro em volume e certificações com clientes estratégicos pode fazer toda a diferença.

A SK hynix, por sua vez, tem um recado ainda mais direto: sua exposição à DRAM e HBM a posiciona no centro do fenômeno da IA. As previsões revisadas indicam que seu margem operacional até 2027 poderá atingir cerca de 74%, com o segmento de DRAM (incluída a HBM) servindo como alicerce do crescimento. Os resultados recentes da SK hynix já refletem essa tendência, com a empresa registrando números recordes impulsionados pela demanda por memória ligada à IA.

No entanto, a parte mais intrigante deste debate não é apenas o volume de lucros projetados, mas o contraste em relação ao tamanho de mercado e a comparação com gigantes tecnológicos dos Estados Unidos. Com uma taxa de câmbio recente em torno de 1.440 wons por dólar, essas cifras de lucro operacional para 2027 poderiam equivaler a cerca de 220 bilhões de dólares para a Samsung e 156 bilhões de dólares para a SK hynix. Para efeito de comparação, no exercício de 2025, a Apple registrou um lucro operacional de 133 bilhões de dólares, enquanto a Alphabet (Google) apresentou 129 bilhões. A soma de ambos (262 bilhões) ficaria abaixo da soma projetada para os dois fabricantes sul-coreanos.

Ainda assim, o mercado frequentemente ignora um fator crucial: a memória tem sido tradicionalmente um negócio marcado por ciclos bruscos. Portanto, a questão não é somente “quanto podem ganhar”, mas sim “por quanto tempo” poderão sustentar isso sem que uma expansão de capacidade, uma desaceleração da economia ou uma mudança tecnológica impactem os preços e margens.

O argumento que está ganhando força entre os investidores é que a memória — especialmente a HBM — está se tornando um recurso crítico, quase estratégico, para a implementação da IA em larga escala. Se a GPU simbolizou o boom, a memória começa a ser vista como sua limitação prática: sem a quantidade suficiente de HBM/DRAM avançada, os aceleradores não entregam o desempenho esperado e os projetos se tornam mais caros.

Esse cenário, contudo, não é garantido. A indústria ainda enfrenta riscos clássicos, como um aumento acelerado de investimentos que pode levar a uma sobrecapacidade, pressão geopolítica sobre as cadeias de suprimento, concorrência agressiva e possíveis ajustes de demanda caso o gasto em IA se normalize. No entanto, a curto prazo, o mercado parece estar ciente de uma realidade muito concreta: a IA não apenas necessita de computação, mas também de memória… e em grande quantidade.