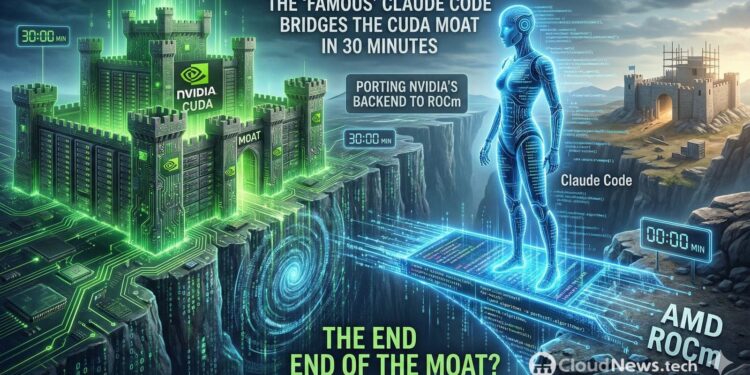

Um recente debate na comunidade de GPUs ganhou destaque em um post viral no Reddit, levantando questões sobre a real capacidade da “muralha” do CUDA — a combinação de APIs e bibliotecas proprietárias da NVIDIA — diante de novas ferramentas de programação assistida por agentes, como o Claude Code da Anthropic.

Um usuário afirmou ter realizado a migração de um backend completo de CUDA para ROCm em apenas 30 minutos, sem o uso de camadas de tradução intermediárias. O único desafio significativo enfrentado foi a diferença no layout de dados. Essa declaração, no entanto, gerou discussões acaloradas sobre até onde a automação pode realmente facilitar a migração de código.

A AMD, que já promove o ROCm há anos como uma plataforma para computação acelerada em GPU, baseia sua estratégia de compatibilidade na ferramenta HIP, que busca tornar parte do código CUDA portátil com mudanças razoáveis. Embora a empresa disponibilize ferramentas como o HIPIFY para traduzir automaticamente código de CUDA para HIP C++, a migração efetiva envolve aspectos mais complexos, como manter a correção dos resultados e otimizar o desempenho, o que vai além da simples recompilação.

Se a ferramenta de programação assistida por agentes realmente encurtar drasticamente o tempo necessário para a tradução inicial, o foco do debate mudará. A questão não será mais “se é possível portar”, mas “quais são os custos de validação e otimização do portado”, e “quantos casos ainda ficam fora da automação”.

Apesar do entusiasmo em torno de um pull request que introduz um backend ROCm no projeto Leela Chess Zero, vale destacar que, embora exista um produto técnico palpável, a conclusão de que o “fim da muralha do CUDA” foi atingido ainda não é uma evidência universal. O verdadeiro teste da migração passará por análises de desempenho e testes funcionais rigorosos que assegurem a equivalência dos resultados.

As ferramentas assistidas são eficazes em tarefas de transformação mecânica, como mapeamento de chamadas CUDA a equivalentes em HIP e reestruturação de arquivos e flags de compilação, mas a complexidade da migração vai muito além de simples substituições de sintaxe. A questão da otimização específica de hardware, as diferenças semânticas e as dependências do ecossistema ainda representam barreiras significativas.

No cenário atual, a possibilidade de que a redução dos custos de portabilidade favoreça a adoção de soluções multi-vendor pode alterar a dinâmica do mercado de GPUs. Para a AMD, cada relato de migração rápida é uma oportunidade de marketing, enquanto a NVIDIA enfrenta o desafio de manter sua dominância em um mercado que começa a olhar para o CUDA como uma opção, em vez de um padrão exclusivo.

Este debate ocorre em um contexto mais amplo, onde iniciativas para diminuir a dependência de plataformas específicas, como soluções de compatibilidade e projetos comunitários, continuam a emergir. O uso de agentes para automatizar algumas etapas do processo pode, de fato, mudar a equação de custos, mas a conclusão de que a muralha do CUDA se quebrou ainda é prematura. As barreiras de formação, ferramentas maduras, bibliotecas dominantes e suporte técnico continuam a ser fatores que sustentam a liderança da NVIDIA no setor.