Arm desafia o domínio das GPUs na inteligência artificial com nova abordagem

Durante anos, a narrativa sobre a infraestrutura de inteligência artificial (IA) teve um único protagonista: as unidades de processamento gráfico (GPUs). No entanto, a Arm está promovendo uma visão inovadora e, para muitos, inevitável: a verdadeira escalabilidade da IA só pode ser alcançada por meio de um design de sistema completo, onde as unidades centrais de processamento (CPUs) – e, cada vez mais, as unidades de processamento de dados (DPUs) – se tornam a cola que permite que os aceleradores entreguem valor real.

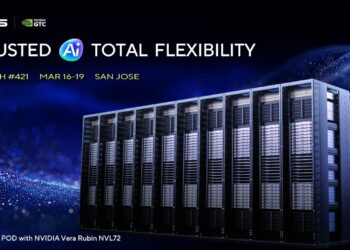

O argumento da Arm ganha força com a recente apresentação da NVIDIA sobre o Rubin durante o CES 2026, que é vista como uma validação do movimento da indústria em direção a racks e superclústeres “co-desenhados”. Esses sistemas, que integram computação, rede, armazenamento e segurança em um único produto, colocam os CPUs baseados na Arm em destaque como a camada de orquestração, coordenação e controle.

A transição do mantra “mais GPUs” para um “centro de dados convergente” é significativa. Arm sintetiza essa mudança com uma frase impactante: os aceleradores realizam os cálculos, mas os CPUs transformam essa potência em sistemas utilizáveis, gerenciando o movimento de dados, sincronização, isolamento e confiabilidade em larga escala. Em um mundo de modelos de IA mais complexos e autônomos, o gargalo não é apenas o número de operações por segundo (FLOPs), mas a capacidade de alimentar, coordenar e proteger as fábricas de IA.

Nesse contexto, a ideia de um “centro de dados convergente de IA” emerge como uma solução: infraestruturas densas, modulares e altamente integradas que maximizam a computação por metro quadrado, ao mesmo tempo que procuram conter os custos energéticos e operacionais.

No evento, a NVIDIA apresentou o Rubin como uma plataforma de “co-design extremo”, composta por seis componentes principais: Vera CPU, Rubin GPU, NVLink 6 Switch, ConnectX-9 SuperNIC, BlueField-4 DPU e Spectrum-6 Ethernet Switch. O objetivo não é apenas aumentar o desempenho, mas também reduzir custos e tempos em treinamento e inferência à medida que se escala para níveis de rack.

NVIDIA destacou promessas de desempenho, como até 10 vezes menos custo por token na inferência em comparação com a geração anterior e até quatro vezes menos GPUs necessárias para treinar modelos Mixture-of-Experts (MoE). O anúncio também mencionou colaborações com empresas como a Microsoft, que está implementando superfábricas de IA baseadas nos sistemas Vera Rubin.

Um ponto interessante na abordagem da Arm é a ênfase na função do DPU. A BlueField-4, por exemplo, não é apenas uma placa de rede, mas um processador de infraestrutura capaz de aliviar funções críticas do CPU. Em paralelo, a NVIDIA introduziu uma plataforma de armazenamento voltada para IA, chamada AICON, que visa aumentar a eficiência e a velocidade no processamento de dados.

Esse movimento também é observado na AWS, que lançou o Trainium3, integrando aceleradores, CPUs e componentes de infraestrutura para formar um sistema coeso, reforçando o argumento de que a abordagem de “apenas mais um acelerador” está se tornando obsoleta.

Assim, o que isso implica para o mercado? Em primeiro lugar, o CPU deixa de ser considerado um elemento secundário na IA. Em segundo lugar, a infraestrutura está se transformando em um produto, com uma crescente ênfase na compra de plataformas completas. Por último, redes e armazenamento estão se tornando fatores críticos reais na corrida pela eficiência e pelo desempenho em IA.

À medida que as empresas navegam por essa nova era de integração e co-design, as mudanças estão rápidas e contínuas, sinalizando uma transformação significativa em como a IA é implementada e escalada no futuro.