Qualcomm Revoluciona Inferência de IA com Novas Soluções AI200 e AI250

A Qualcomm anunciou importantes avanços na inferência de inteligência artificial (IA) em centros de dados com o lançamento das soluções AI200 e AI250. Estas inovações visam oferecer desempenho robusto a um custo total de propriedade (TCO) competitivo, focando na eficiência ao executar modelos generativos.

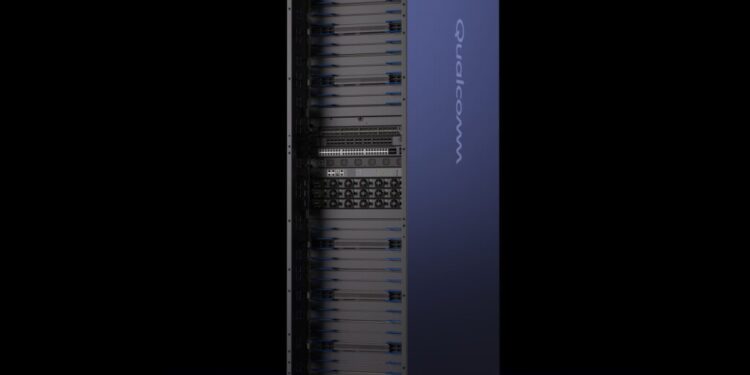

As soluções serão comercializadas como placas e racks completos, prometendo desempenho de nível rack, maior capacidade de memória e uma abordagem otimizada para o uso de energia. Durga Malladi, SVP & GM da Qualcomm Technologies, destacou que suas novas tecnologias redefinem as capacidades de inferência em larga escala sem comprometer a segurança ou a flexibilidade exigidas pelos modernos centros de dados.

Com uma previsão de lançamento escalonada, a solução AI200 estará disponível em 2026 e a AI250 em 2027. Ambas estão alinhadas com uma estratégia a longo prazo que prioriza melhorias constantes em eficiência energética e desempenho.

Soluções Focadas nas Necessidades do Mercado

A AI200 se destaca por sua memória de até 768 GB LPDDR por placa. Essa quantidade triplica a memória disponível em muitos aceleradores atuais, permitindo que a GPU maneje contextos longos e lotes maiores sem comprometer o desempenho.

Enquanto isso, a AI250 introduz a arquitetura de ‘near-memory computing’, que promete aumentar o largura de banda efetivo em mais de dez vezes e reduzir o consumo de energia, focando na eficiência e no desempenho em inferências.

Ambas as ofertas podem ser adquiridas como racks prontos para produção, operando com até 160 kW por rack, equipados com refrigeração líquida e suporte para protocolos PCIe e Ethernet, permitindo uma escalabilidade modular.

Preparação para o Futuro da Inferência

O suporte da Qualcomm se estende além do hardware, oferecendo uma pilha de software otimizada para facilitar a integração e operação das novas soluções. O objetivo é transformar a implementação de IA em um processo ágil com menos fricções, permitindo uma adoção mais rápida de modelos e frameworks já estabelecidos no mercado.

Com essas inovações, a Qualcomm solidifica sua posição no competitivo campo da inferência de IA, atendendo às crescentes demandas por soluções escaláveis e economicamente viáveis em um cenário tecnológico em constante evolução. As empresas precisam se preparar para uma nova era na qual o desempenho da inferência e a eficiência de custos se tornam essenciais para a implementação em larga escala de IA generativa.