A indústria de semicondutores está vivenciando uma revolução impulsionada pela crescente demanda por inteligência artificial (IA), com inovações que há alguns anos pareciam ficção científica. Recentemente, surgiram informações de que a Meta e a NVIDIA estão em negociações para integrar núcleos de GPU diretamente na memória HBM (High Bandwidth Memory) de última geração, em colaboração com os gigantes sul-coreanos SK hynix e Samsung Electronics.

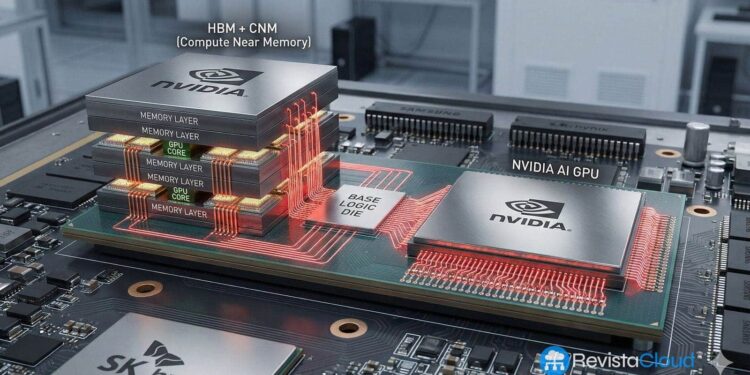

Essa nova arquitetura, que pode ocorrer em produtos comerciais no futuro, tem o potencial de transformar significativamente o design dos chips para centros de dados de IA, desvanecendo as barreiras tradicionais entre memória e processadores. A HBM foi desenvolvida para solucionar problemas de largura de banda entre o processador e a RAM em sistemas de alto desempenho, empilhando camadas de DRAM conectadas por vias através do silício (TSV). Este design resulta em módulos compactos que oferecem uma largura de banda muito maior do que as memórias tradicionais, além de consumir menos energia e ocupar menos espaço físico.

Atualmente, a HBM é utilizada principalmente para armazenar e fornecer dados rapidamente ao processador. No entanto, com a introdução do HBM4, ocorre uma mudança significativa: alguns fabricantes estão começando a incorporar controladores de memória mais avançados, capazes de otimizar a gestão dos dados com redução de latências. A proposta de integrar núcleos de GPU nesse contexto levaria essa inovação a um nível superior, permitindo que operações computacionais fossem realizadas diretamente na memória, sem a necessidade de transferir dados para o processador principal.

Essa abordagem pode ter um impacto profundo nos centros de dados, onde o movimento constante de dados entre memória e processador gera desperdício energético e latência. A redução da distância física entre onde os dados são armazenados e processados minimiza o tráfego entre a HBM e a GPU principal, resultando em ganhos de eficiência. Especialistas destacam que a nova meta na IA não é apenas maior velocidade, mas principalmente a eficiência energética por operação.

Apesar do grande potencial, implementar essa arquitetura não é uma tarefa simples. Há limitações significativas em relação ao espaço disponível, à energia consumida e ao calor gerado pelos núcleos de GPU integrados. Esses desafios exigem um reestudo do design e da gestão térmica para garantir que a memória e a lógica possam coexistir de maneira eficiente.

As colaborações entre Meta, NVIDIA, SK hynix e Samsung sinalizam uma mudança importante no setor, onde empresas de memória e lógica tradicionalmente separadas estão agora se unindo para desenvolver soluções inovadoras. Se essas parcerias conseguirem superar os desafios técnicos e trazer ao mercado HBM integrado com núcleos de GPU, poderemos ver o surgimento de novas categorias de aceleradores e um aumento na fragmentação do mercado, já que fornecedores de nuvem poderão personalizar suas soluções específicas de HBM.

A indústria de semicondutores na Coreia do Sul e globalmente está prestes a enfrentar um período de transformação, onde a memória se tornará um ativo ativo no processamento de dados, movendo-se para uma era em que a eficiência na computação é mais crucial do que nunca.