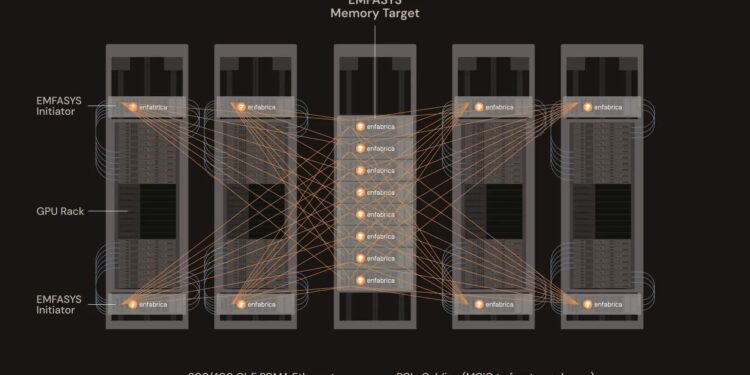

A startup Enfabrica Corporation lançou esta semana o Emfasys, um sistema pioneiro de memória elástica para inteligência artificial que promete otimizar os custos de inferência e aliviar a pressão sobre a memória HBM. Esse novo sistema, baseado inteiramente em Ethernet, visa revolucionar a eficiência em cargas de trabalho de inferência em larga escala, expandindo a capacidade de memória dos servidores GPU.

Com capacidade para oferecer até 18 TB de memória DDR5 por nó, o Emfasys possibilita o acesso através de conexões padrão de Ethernet de 400 e 800 GbE, utilizando tecnologias como RDMA e CXL. A Enfabrica destaca que essa solução pode reduzir o custo por token gerado em até 50%, especialmente em cenários com múltiplas interações e janelas de contexto ampliadas.

Rochan Sankar, CEO da Enfabrica, afirma que “a inferência de IA enfrenta desafios de escalabilidade de largura de banda de memória”, e explica que o Emfasys é uma resposta a esse cenário, proporcionando uma nova abordagem para o acesso à memória.

A nova arquitetura é baseada no chip ACF-S SuperNIC, que oferece um desempenho de 3,2 Tbps e permite a interconexão de servidores GPU com memória DDR5 através do protocolo CXL.mem. O sistema também almeja facilitar o emprego da tecnologia com um software de memória remota compatível com RDMA, eliminando a necessidade de redesenhar a estrutura de hardware ou software existente.

O crescimento dos modelos generativos, que requerem de 10 a 100 vezes mais recursos do que suas versões anteriores, está pressionando a infraestrutura de IA. Enfabrica vê no Emfasys uma solução escalável, especialmente em ambientes de nuvem, onde a rapidez na geração de tokens é crucial para a economia total.

Ainda em fase de avaliação, a nova tecnologia já está nos testes de alguns clientes. Enfabrica faz parte do consórcio Ultra Ethernet Consortium (UEC), colaborando no desenvolvimento do padrão emergente Ultra Accelerator Link (UALink).

Recentemente, a startup também fechou uma rodada de investimento Série B de 125 milhões de dólares, com participação de Sutter Hill Ventures e NVIDIA, reforçando sua posição como líder em infraestrutura de memória distribuída para inteligência artificial generativa.