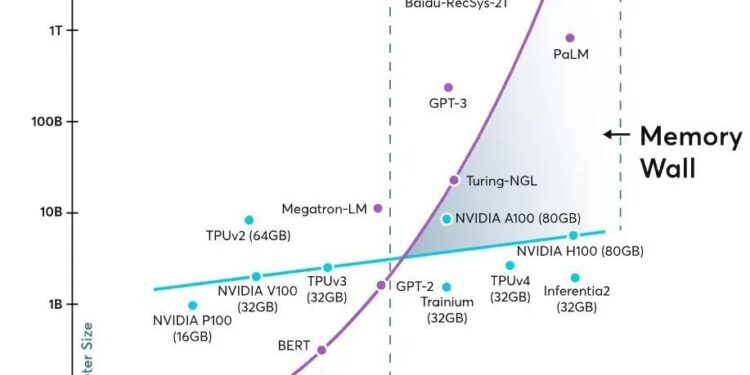

A pressão sobre a infraestrutura de Inteligência Artificial (IA) está mudando a forma como as empresas encaram o desenvolvimento tecnológico. Nos últimos anos, o foco estava na escassez de GPUs, mas a partir de 2026, a narrativa começa a incluir um novo conceito: a “pared de memória”. Esta expressão, cada vez mais popular entre acadêmicos e profissionais do setor, refere-se não apenas à ausência de memória, mas a um conjunto de desafios envolvendo capacidade, largura de banda e latência que limitam a transferência de dados entre os processadores e suas memórias.

Com o crescimento exponencial do tamanho dos modelos de IA, as necessidades de movimentação de dados, como parâmetros e ativações, tornam-se cada vez mais cruciais. Isso resulta em um cenário onde as unidades de processamento gráfico (GPUs) não estão sendo utilizadas de maneira eficiente, à medida que não recebem dados suficientes em tempo hábil. Historicamente, isso já havia sido um problema no setor de computação tradicional, mas agora essa situação se repete em uma escala industrial.

Essa nova realidade está impulsionando investimentos significativos no desenvolvimento de tecnologias de memória, como a High Bandwidth Memory (HBM), que promete resolver o problema da largura de banda por watt de energia. Empresas como Micron Technology estão investindo bilhões em novas fábricas e instalações para atender à crescente demanda por memória avançada, como visto em sua recente decisão de investir 24 bilhões de dólares em uma nova unidade em Cingapura.

Além disso, o papel da memória flash está ganhando destaque, especialmente para armazenamento rápido de checkpoints e conjuntos de dados massivos. O aumento na demanda por SSDs de alto desempenho está permitindo que as empresas evitem gargalos e otimizem seus fluxos de trabalho.

Grandes operadores de nuvem, como Google, Amazon e Microsoft, estão sendo levados a repensar suas estratégias para garantir que suas GPUs operem na máxima capacidade. Em vez de somente comprar hardware adicional, a abordagem agora requer um sistema arquitetônico mais sofisticado que misture diferentes tipos de memória para maximizar a eficiência.

Com isso, o futuro da IA está se tornando não apenas uma questão de potência bruta, mas de como gerenciar e otimizar a arquitetura de sistemas. À medida que a indústria evolui, a memória se estabelece como um componente crítico no desempenho geral dos centros de dados, e não como um mero acessório.